Milí přátelé,

vítejte v první části kurzu AI dětem. Je zaměřen na teoretickou rovinu AI: Jak daleko sahá její historie? Co to je a jak funguje strojové učení? Které významné změny tato technologie přináší do našeho světa? Kde všude dnes AI najde své využití? Jaké jsou její právní aspekty? Co je to etická práce s daty a etika umělé inteligence obecně? Jaké jsou největší výzvy, které musí naše společnost v souvislosti s AI zvládnout? A jaké jsou argumenty pro vzdělávání se v této oblasti?

Proč je dobré vzdělávat sebe i děti v oblasti AI

15 700 000 000 000 $

Předpokládaný přínos umělé inteligence pro světovou ekonomiku do r. 2030.

Investice do oblasti umělé inteligence ze soukromého sektoru v roce 2023

Spojené státy americké (67 mil. $)

Čína (7,8 mil. $)

Velká Británie (3,8 mil. $)

Německo (1,9 mil. $)

Regulace umělé inteligence

Na poli Evropské unie reguluje AI dokument nazvaný Akt o umělé inteligenci. Přehledně zpracovaného průvodce o evropských regulacích umělé inteligence nabízí Česká asociace umělé inteligence.

Dopad umělé inteligence na trh práce

Výzkum Goldman Sachs Global Investment Research odhaduje, že jedna čtvrtina současných pracovních pozic by mohla být v USA (v EU podobně) automatizována umělou inteligencí, přičemž obzvláště vysoká pravděpodobnost je v administrativních (46 %) a právnických (44 %) profesích a nízké riziko ve fyzicky náročných profesích, jako je stavebnictví (6 %) a údržba (4 %).

AI gramotnost a kompetence

Většina z nás se denně potkává s aplikacemi umělé inteligence, ale ne vždy rozumíme technologiím, které za tím stojí. Tato mezera v gramotnosti (AI Literacy Gap) společně s častým využíváním AI může vést ke zranitelnosti a snadné zmanipulovatelnosti. Měli bychom porozumět nejen potenciálu umělé inteligence, ale také rizikům, jež tato přelomová technologie přináší.

Proměna práce pedagoga

Technologie jsou prostředkem, jenž může být velmi nápomocný jak žákům, tak učitelům. Na následujícím obrázku je odhad, která část stávajících týdenních pracovních povinností učitele může být v budoucnosti realizována umělou inteligencí.

Technologie je taková, jaká je společnost

Následující video ukazuje žáky v Číně, jejichž soustředění může pedagog monitorovat v reálném čase pomocí EEG. Zatímco mnozí rodiče a učitelé podobné technologie považují za nástroje ke zlepšení známek, některé děti je vnímají spíše negativně.

Z evropského pohledu je takový přístup k dětem ve školách těžko představitelný, jelikož směřujeme naopak k regulaci umělé inteligence (The AI Act).

Jak vnímají generativní umělou inteligenci děti

Výzkum Národní rady 4-H (USA) z roku 2024, který proběhl na 1 500 dětech a mladých lidech ve věku 9—17 let ukazuje, že chtějí, aby jim dospělí pomohli s používáním nástrojů umělé inteligence. I když jsou mladí optimističtí ohledně potenciálu AI, cítí potřebu dospělého vedení k řešení etických, vzdělávacích a kariérních otázek. Mají obavy o soukromí a zabezpečení dat a mnozí si myslí, že by se výuka AI měla začít už v raném věku. Cílem průzkumu je informovat vzdělavatele, rodiče a tvůrce politik o významu spolupráce v oblasti AI vzdělávání.

Hlavní zjištění

66 % respondentů alespoň částečné rozumí, co je generativní AI a jak ji používat.

72 % by uvítalo podporu při vzdělávání s nástroji generativní AI od dospělých.

64 % si myslí, že generativní AI jim pomůže v budoucí kariéře.

58 % uvedlo, že jim generativní AI pomůže zlepšit učení ve škole.

61 % má obavy, že by mohla být generativní AI zneužita k podvádění.

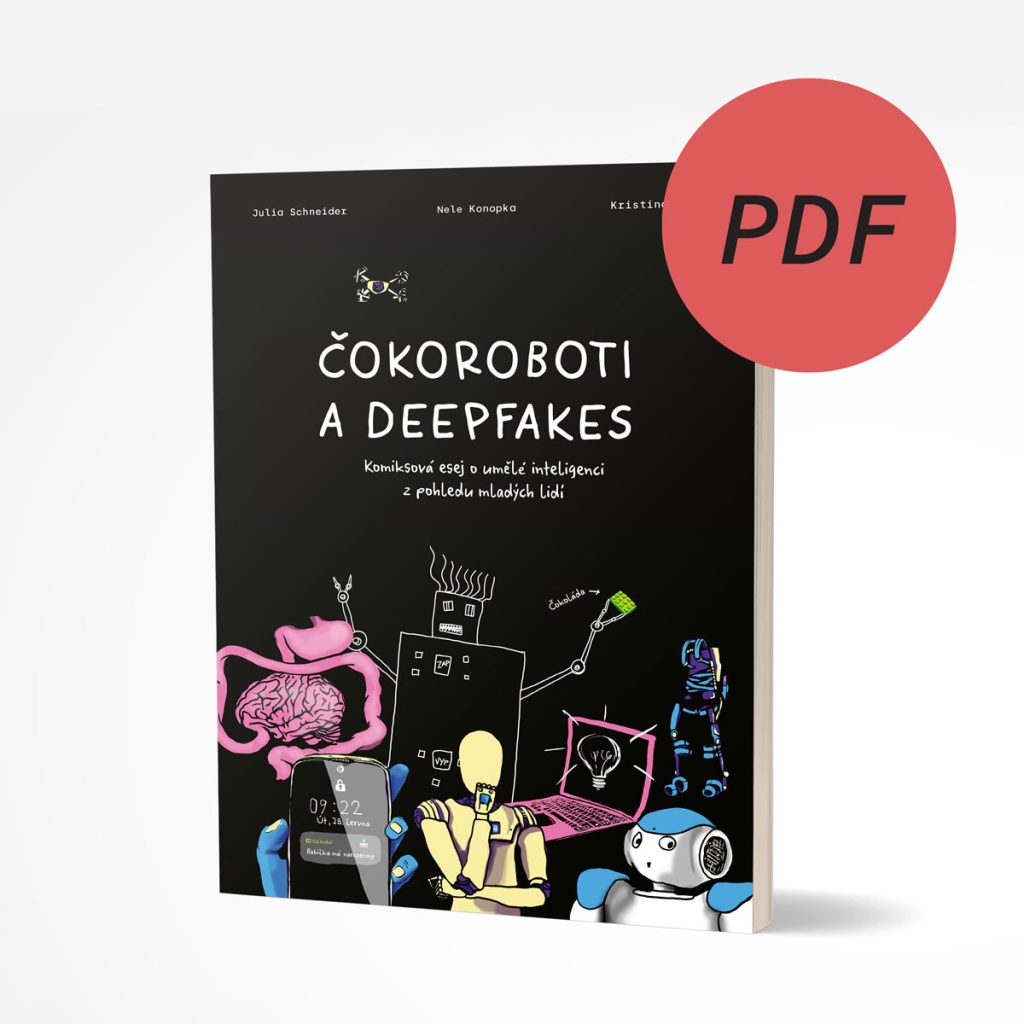

Komiks Čokoroboti a deepfakes

Jak vnímá umělou inteligenci generace, na kterou bude mít největší dopad? Komiks složený z představ mladých lidí (od 11 do 19 let) o AI nejen vzdělává, ale doplňuje důležitým dílkem skládačku etiky AI.

Ovšem když přijde řeč na AI...

... mnohdy ji lidé (nejen děti) vnímají jako něco, co nás ohrožuje. Pravděpodobně to vychází z popkultury. Vzpomínáte na Skynet ve filmu Terminátor? Pojďme si v tom udělat pořádek.

Úzká AI

Tzv. „Narrow AI“ je typ umělé inteligence, kterou využíváme v současnosti. Je specializovaná na konkrétní úkol nebo omezenou sadu úkolů. Mohou to být např. programy pro rozpoznávání obrazu, doporučovací systémy, překladače a další.

Obecná AI

Obecná nebo také AGI z anglického „Artificial General Intelligence“ je AI, která má schopnost pochopit, učit se a uplatňovat znalosti napříč širokou škálou úloh na úrovni srovnatelné s lidským intelektem. V současné době je pouze hypotetickým konceptem, avšak o její vybudování se vědci intenzivně snaží.

Superinteligence

AI, která významně překračuje schopnosti lidí ve vědeckých, tvůrčích i sociálních aspektech. Mohla by vylepšovat své vlastní algoritmy a schopnosti rychlostí, kterou lidský intelekt nemůže dosáhnout nebo předvídat. Také superinteligence je hypotetickým konceptem.

Stručná historie umělé inteligence

Za méně než sto let se umělá inteligence proměnila z okrajové disciplíny teoretické matematiky v něco, s čím se každodenně setkávají miliony lidí po celém světě. Proklikněte se na časovou osu a podívejte se na nejdůležitější milníky vývoje umělé inteligence. Představí momenty, kdy se stroje naučily komunikovat, vnímat své okolí, samostatně se pohybovat nebo překonat člověka v řešení nejrůznějších problémů.

Co je to vlastně AI

Počítačový program a vědecký obor

Přestože je termín umělá inteligence v poslední době často skloňován, lidé se neshodují v tom, co přesně znamená. Ani samotná definice vlastně není ustálená. Jedna z možných variant zní takto: program, který simuluje lidské myšlení a akce.

Umělá inteligence je zároveň také vědecký obor s počátky sahajícími do první poloviny 20. století. Jeho důležitým přínosem je, že se inteligentním systémům snaží nejen porozumět, ale zejména je tvořit.

Umělá inteligence má obvykle formu počítačového programu a slouží k řešení úloh, k nimž byl dříve potřeba značný lidský intelekt, a byly tedy doménou lidí (nebo v některých případech zvířat).

Chování člověka i dalších inteligentních živočichů systémy umělé inteligence často napodobují, a vcelku běžně tedy mívají schopnost vnímat, učit a přizpůsobovat se. Důležité je, že nemusí jít o roboty, jak si lidé často myslí — systémy umělé inteligence si ke svému fungování ve většině případů vystačí s počítačem.

Kde všude nám dnes AI slouží

Dokázali byste identifikovat, kde se s AI denně setkáváme?

- Doporučuje obsah ve vyhledávání, na sociálních sítích nebo třeba na streamovacích platformách jako Netflix či Spotify.

- Navrhuje nejvhodnější cestu například v navigaci Google nebo Waze.

- Překládá z jednoho jazyka do druhého — překladač Google nebo DeepL.

- Předpovídá počasí — Meteoradar…

- Generuje texty, obrazy, videa, 3D objekty — například ChatGPT, Midjourney a mnohé další aplikace.

- Zjednodušuje život pomocí hlasových asistentů — Siri, Google…

- Třídí poštu ve vaší e-mailové schránce.

- Vylepšuje mobilní nebo jiné hry například formou inteligentních agentů.

- Personalizuje online obchod — Amazon…

- Opravuje texty, které píšete, například v Google Docs, Office 365…

- A mnoho dalšího!

Umělá inteligence je v současném světě velkým přínosem v mnoha oblastech.

- Pomáhá analyzovat rentgenové a další snímky a identifikovat známky onemocnění, které mohou být pro lidské oko obtížně rozpoznatelné.

- Dokáže vyhodnocovat zdravotní údaje pacientů a predikovat riziko onemocnění.

- Na základě genetických informací může AI doporučit léčebné plány šité pacientům na míru.

- Chirurgičtí roboti řízení AI mohou provádět složité operace s větší přesností.

- AI pomáhá i s administrativou a zjednodušuje konverzace mezi pacientem a zdravotnickým personálem jako osobní asistent.

- AI může analyzovat různé věci, jako provoz, počasí a stav vozidla, aby navrhla nejefektivnější trasu.

- Systémy AI mohou na základě sledování předpovídat, kdy vozidlo potřebuje údržbu.

- Roboti řízení AI mohou automatizovat procesy balení a vykládání.

- AI může optimalizovat spotřebu energie v budovách a domácnostech.

- V zemědělství mohou systémy AI monitorovat a analyzovat půdní data, aby rostliny dostávaly přesné množství vody a živin, které potřebují.

- S pomocí dronů a senzorů může AI monitorovat pole a aplikovat hnojiva a pesticidy pouze tam, kde je to nezbytné, což šetří suroviny a snižuje environmentální dopad.

- Z dat získaných pomocí senzorů může AI sledovat spotřebu vody v reálném čase a upozornit, pokud je nadměrná.

- AI může analyzovat výrobní procesy a určit oblasti, kde je možné šetřit surovinami a energií.

- Pomocí AI lze automatizovat třídění odpadu a optimalizovat logistiku jeho sběru.

- Výroba: AI může monitorovat a řídit výrobní linky, aby se minimalizovaly chyby a zvyšovala efektivita.

- Finance: Systémy AI mohou vyhodnocovat transakční data a detekovat podvodné aktivity.

- Věda a výzkum: AI může pomáhat vědcům analyzovat velké množství dat a provádět složité simulace.

- Vzdělávání: AI může personalizovat učební plány na základě individuálních potřeb a výsledků.

- Městské plánování a infrastruktura: AI může pomoci městům sledovat provoz na silnicích nebo plánovat stavby.

Jak se umělá inteligence učí

Strojové učení

Stejně jako se člověk umí učit z příkladů a zkušeností, jsou toho schopny i člověkem vytvořené stroje. K tomu slouží metoda, která se nazývá strojové učení. Cílem strojového učení je odhalit vzory vyskytující se v datech.

Strojové učení přináší zásadní změnu ve způsobu, jakým vytváříme stroje. Místo toho, abychom jim přesně popisovali nějaký postup, ukážeme jim velké množství příkladů, ze kterých se samy naučí, jak vykonávat konkrétní úlohy.

Představte si to na příkladu robotů, které bychom chtěli naučit hrát fotbal. Pokud bychom se snažili napsat algoritmus, který by popisoval všechny situace na hřišti a jak na ně mají roboti reagovat, bylo by to velmi zdlouhavé, ne-li nemožné. A tak místo toho vytvoříme pro roboty program, který je schopen se z mnoha příkladů naučit hrát fotbal sám. Třeba takhle:

Jaké jsou rozdíly mezi těmito přístupy, popisuje studie výzkumníků Matti Tedreho a Henriikky Vartiainen:

Přístup založený na algoritmech

Formalizace problému

Návrh řešení v podobě algoritmu

Implementace řešení krok za krokem

Kompilace a spuštění programu

Přístup založený na strojovém učení

Popis problému a sběr dat

Čištění, úprava a anotace dat

Trénování programu strojového učení

Testování programu a jeho případná úprava

V rámci přístupu založeného na datech (data-driven) je tou hlavní náplní experimentování s daty a výsledkem je pravděpodobnostní model. Naopak algoritmický přístupu (rule-driven) má jasnou strukturu a jeho výstup je deterministický (výsledek je stejný).

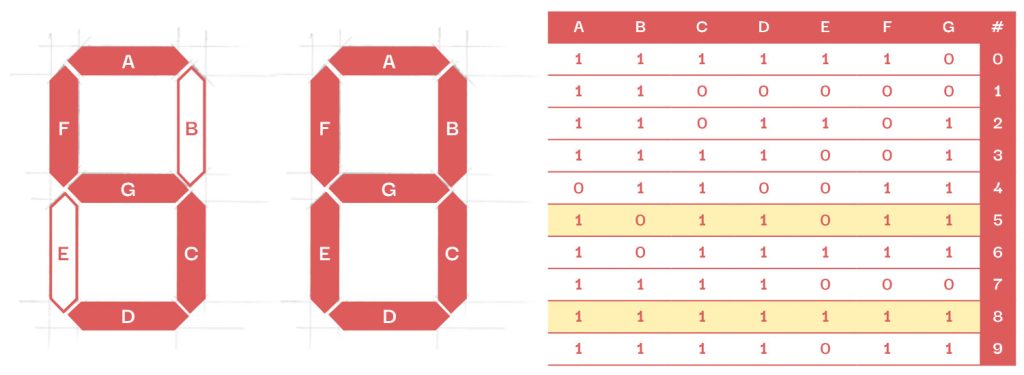

Představme si, že chceme naučit počítač rozpoznávat čísla 5 a 8. Jak by se lišil postup v případně algoritmického přístupu a strojového učení?

Algoritmický přístup

Čísla 5 a 8, jak je známe například z kalkulačky, bychom mohli strojům popsat pomocí této tabulky:

Plošky, které svítí (jsou červené), jsou v tabulce reprezentovány jako číslo 1. Plošky, které nesvítí, jako číslo 0. Jenomže pracujeme-li s takto přesnou definicí, náš program pochopitelně selže, pokud mu následně ukážeme ručně psané číslice.

Ba co víc, takový program dokonce nedokáže pracovat s jinou reprezentací dat, než je sedm jedniček a nul.

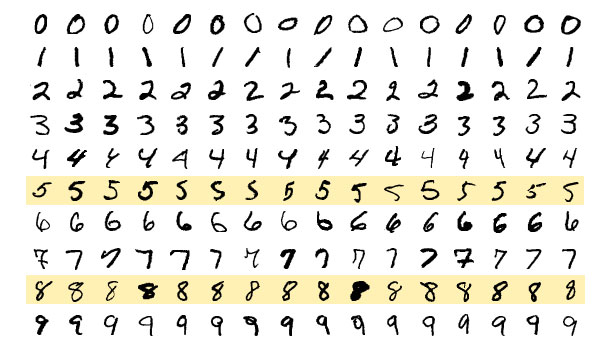

Strojové učení

V rámci tohoto přístupu bychom programu ukázali velké množství obrázků číslic, ze kterých by si vytvořil vlastní reprezentace sám. Například takto:

Toto je ukázka datasetu MNIST — 70 000 číslic, ze kterých se programy strojového učení (modely) učí rozpoznávat číslice.

Je zřejmé, že tento přístup je mnohem složitější. Namísto sepsání několika jednoduchých pravidel musíme trénovat model (vlastně metodou pokusu a omylu, viz níže) na velkém množství dat, která předtím musíme sesbírat a označit.

Obrovskou výhodou ale je, že výsledný model bude — na rozdíl od algoritmického přístupu — fungovat na různě napsaných číslicích.

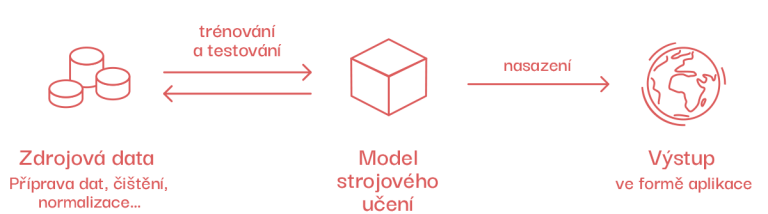

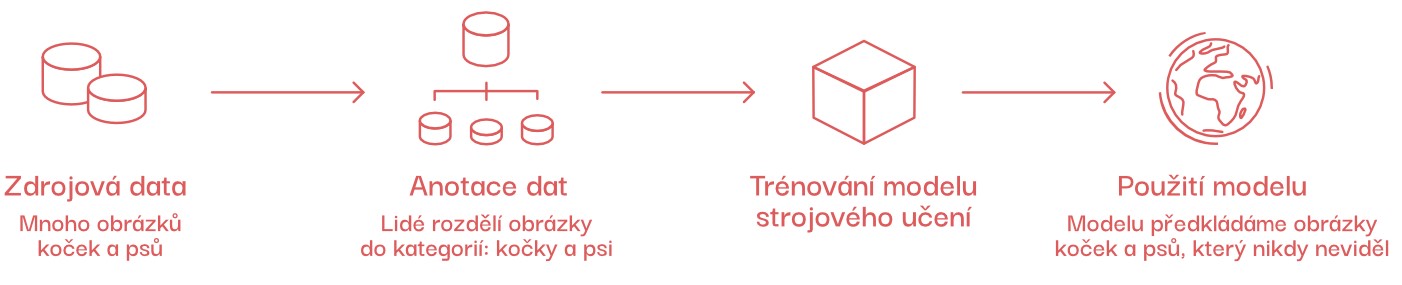

Model strojového učení

Takto se nazývá program, který se z mnoha příkladů učí, jak řešit různé úlohy. Učení probíhá ve dvou fázích — trénování a testování. V trénovací fázi ukazujeme modelu množství příkladů (videa, obrázky, texty…), na nichž se učí tím, že vyhledává vzory (podobnosti). V testovací fázi ukazujeme modelu příklady, které ještě nikdy neviděl, a zjišťujeme, jak dobře funguje.

Typy strojového učení

Strojové učení s učitelem

Pokud bychom chtěli vytvořit pomocí tohoto typu strojového učení aplikaci, která rozpoznává psy a kočky, museli bychom nejdříve systému umělé inteligence říci, na kterých obrázcích jsou kočky a na kterých psi (tzv. anotovat data). Lidé tedy plní úlohu učitelů, podle čehož se tento přístup nazývá.

Po rozdělení obrázků na kočky a psy bychom natrénovali model strojového učení a poté bychom mu ukazovali obrázky koček a psů, které ještě nikdy neviděl.

Sledovali bychom, zda zvíře určil správně. Pokud ne, vylepšili bychom datovou sadu a natrénovali model znovu.

Strojové učení bez učitele

Někdy může být velmi zdlouhavé, nákladné či přímo nemožné všechna data anotovat. V takových případech využíváme strojové učení bez učitele.

Tento typ programu si vyhledává podobnosti (vzory) sám a vstupní data poté dokáže rozdělit do shluků (anglicky cluster), abychom se v datech my lidé lépe vyznali — a především pak snadno určili, co který shluk znamená.

Jedno z prvních využití tohoto typu strojového učení bylo, když mu výzkumníci ukázali 10 milionů videí na YouTube. Program v nich vyhledával podobnosti a jako první určil vzory, které my lidé vnímáme jako kočky! 🙂

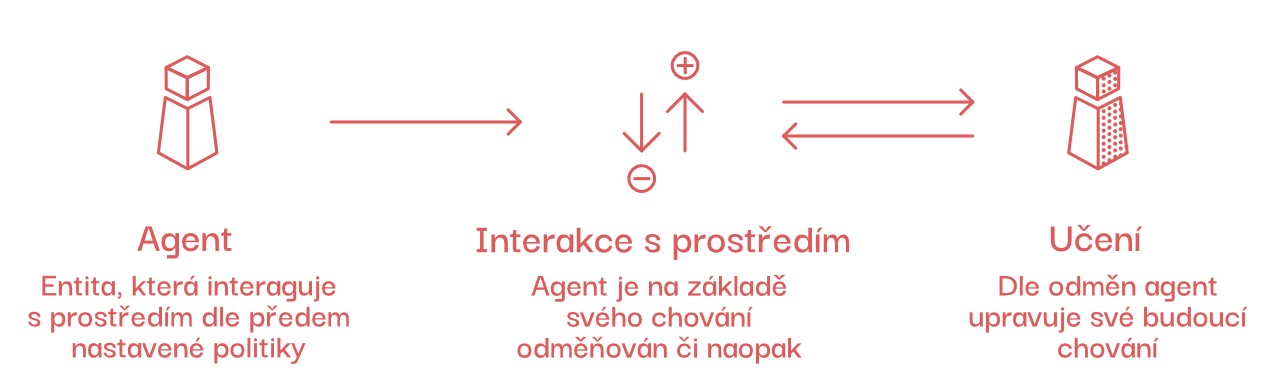

Posilované učení

Někdy necháme stroje, aby něco zkoušely samy, a následně jim dáváme zpětnou vazbu. Takto se třeba program zvaný Agent57 naučil sám hrát hry na konzoli Atari. Nebo se díky tomuto typu strojového učení naučil psí robot vstávat.

Princip posilovaného učení (anglicky Reinforcement Learning, RL) nám nejlépe ukáže slepička:

Stejným způsobem se učí také MENACE — 304 krabiček od zápalek, které můžete naučit hrát piškorky 3×3 tak, že není možné je porazit. MENACE vymyslel a vytvořil v roce 1961 Donald Michie.

Neuronové sítě

Neuronová síť je program, který napodobuje způsob, jakým náš mozek zpracovává informace. Stejně jako jiné algoritmy se učí z dat, aby mohla provádět úkoly jako například rozpoznávání obrázků nebo předpovídání počasí.

Jejím specifikem je využití umělých neuronů – velmi jednoduchých jednotek, které jsou inspirovány neurony biologickými – jež jsou v síti poskládány do po sobě jdoucích vrstev. Informace proudí ze vstupu sítě (například mnoha pixelů obrázku) přes jednotlivé vrstvy až do výstupní vrstvy.

Neuronové sítě jsou jedním z mnoha druhů modelů, které využíváme v různých úlohách. Využívají se pro učení s učitelem, bez učitele i pro posilované učení.

Přestože první umělý neuron byl vytvořen již v roce 1943, muselo lidstvo na svou první neuronovou síť čekat až do padesátých let 20. století. Vytvořil ji inženýr Frank Rosenblatt a nazval ji Mark I perceptron. Tato síť obsahovala jediný perceptron (umělý neuron).

Představte si ji jako jednoduchou elektronickou „mysl“, která se snaží rozhodnout, zda něco patří do jedné kategorie, nebo do druhé, na základě vstupních dat. Funguje tak, že přijímá informace (čísla), váží je podle určitého kritéria a poté rozhodne, do jaké kategorie data patří. Pokud se při prvním pokusu nerozhodne správně, upraví svá kritéria a zkusí to znovu, dokud se nenaučí rozhodovat správně.

Dnes už používáme sítě mnohem větší. Například hluboké neuronové sítě, které stojí za velkými jazykovými nebo obrazovými modely, mohou mít až biliony neuronů.

Proč umělá inteligence diskriminuje

Předpojatost

Termín předpojatost značí jev, kdy nesprávně připravená nebo nevyvážená data způsobí, že systémy umělé inteligence dospějí k řešením, která podporují předsudky nebo mají nezamýšlené a nepříjemné následky.

Vraťme se zpět k naší aplikaci, která rozpoznává psy a kočky. V případě, že bychom modelu ve fázi testování předložili tisíc fotografií koček, které odpočívají doma na křesle, a tisíc fotek psů, kteří běhají venku na trávě, tak by natrénovaný model pravděpodobně rozpoznal kočku chytající motýla na zahradě jako psa.

Proč? Model by považoval za důležitější vzory pozadí na fotografiích, protože to obvykle tvoří většinu plochy obrázku. A modely nemají žádnou intuici, neví samy, co je důležité, a snaží se od sebe příklady oddělit tím nejjednodušším možným způsobem.

Pokud jsou modely natrénované na příkladech (datech), které chybně nebo nevyváženě reprezentují skutečnost, rozhodují se špatně. Pokud necháme klíčová rozhodnutí na systémech, které jsou nesprávně připraveny, může to mít neblahý dopad na naše životy.

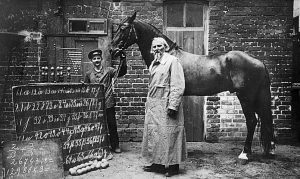

Hans byl kůň žijící na přelomu 19. a 20. století v Německu. Proslavil se svou mimořádnou inteligencí. Údajně byl schopen řešit aritmetické úlohy, číst a rozumět německému jazyku (odpovídal bušením kopytem o zem). Vystupoval s ním jeho majitel Wilhelm von Osten — učitel matematiky a amatérský výzkumník.

Vzhledem k výjimečným schopnostem, které Hans projevoval, se na něj upnula pozornost široké veřejnosti i vědecké komunity. V roce 1907 byla vytvořena komise, složená z expertů z různých oborů, která měla zkoumat jeho schopnosti.

Výzkumníci provedli řadu experimentů a zjistili, že Hans dokázal odpovědět na 89 % otázek správně, když jeho trenér von Osten na otázku odpověď znal. Ale v případě, že ji neznal, Hans odpověděl správně pouze na 6 % otázek.

Komise dospěla k závěru, že kůň reagoval na nevědomé pohyby a signály von Ostena, například pohyby hlavy nebo změny výrazu obličeje. Jednalo se o takzvaný Clever Hans effect či ideomotorický efekt.

Tento příklad velmi dobře ilustruje koncept strojového učení a předpojatosti. Von Osten byl „konstruktérem“ Hansovy inteligence, ale jeho porozumění způsobu, jak se kůň učí, bylo mylné. Podobné je to i s lidským pochopením toho, jak systémy AI interpretují data, na kterých byly natrénovány.

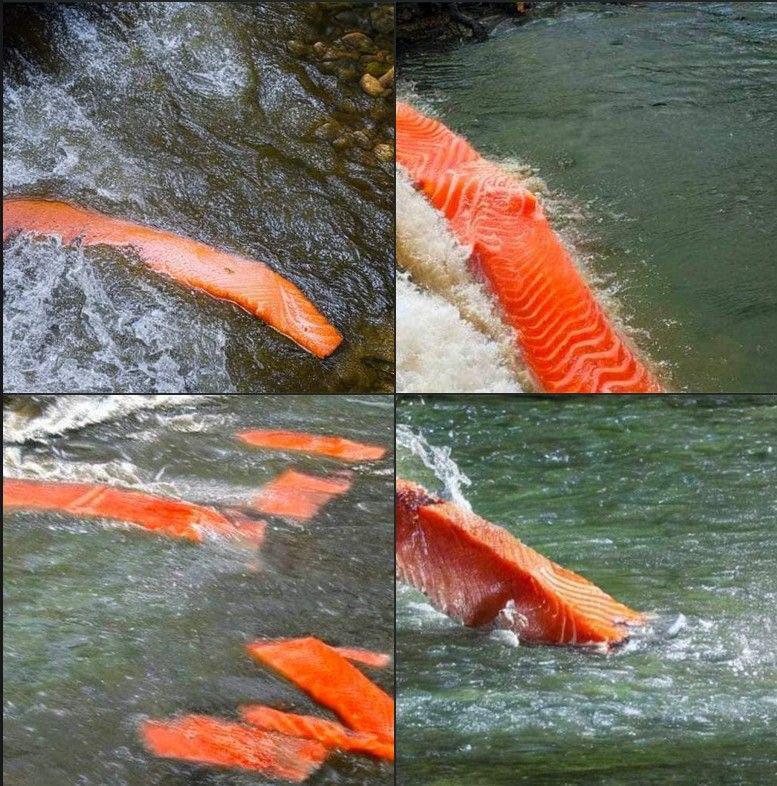

Legrační ukázkou předpojatosti je také obrázek generovaný pomocí umělé inteligence — konkrétně pro zadání (prompt) losos v peřejích (původně „salmon in a river“). Podobné mýlky vznikají jednoduše proto, že generativní model, který obrázek vytvořil, byl natrénovaný na datech, kde byl losos reprezentován častěji jako steak než jako ryba.

Co je to etika umělé inteligence

Algoritmy v souladu s lidmi

Jádrem etiky umělé inteligence je snaha o vytvoření souboru etických pravidel, která všem systémům umělé inteligence umožní rozhodovat se správně.

Zkuste se vcítit do rozhodovacího systému samořídícího auta. Vozovka je mokrá, jedete rychlostí 50 km/h, vezete tři pasažéry a do cesty vám skočí člověk honící míč. Když strhnete volant, narazíte do stromu a ohrozíte pasažéry. Když pojedete rovně, vážně zraníte běžce. Jak se rozhodnete?

Nejen autonomní auta, ale všechny inteligentní systémy dělají mnoho rozhodnutí. Úkolem nás lidí je vytvořit tyto systémy tak, aby se rozhodovaly co nejlépe. Zároveň je zřejmé, že jsou potřeba jiné instrukce například pro domácího robota a jiné pro autonomní dron, který hlídá hranice znepřátelených států.

Velké jazykové modely

Velký jazykový model

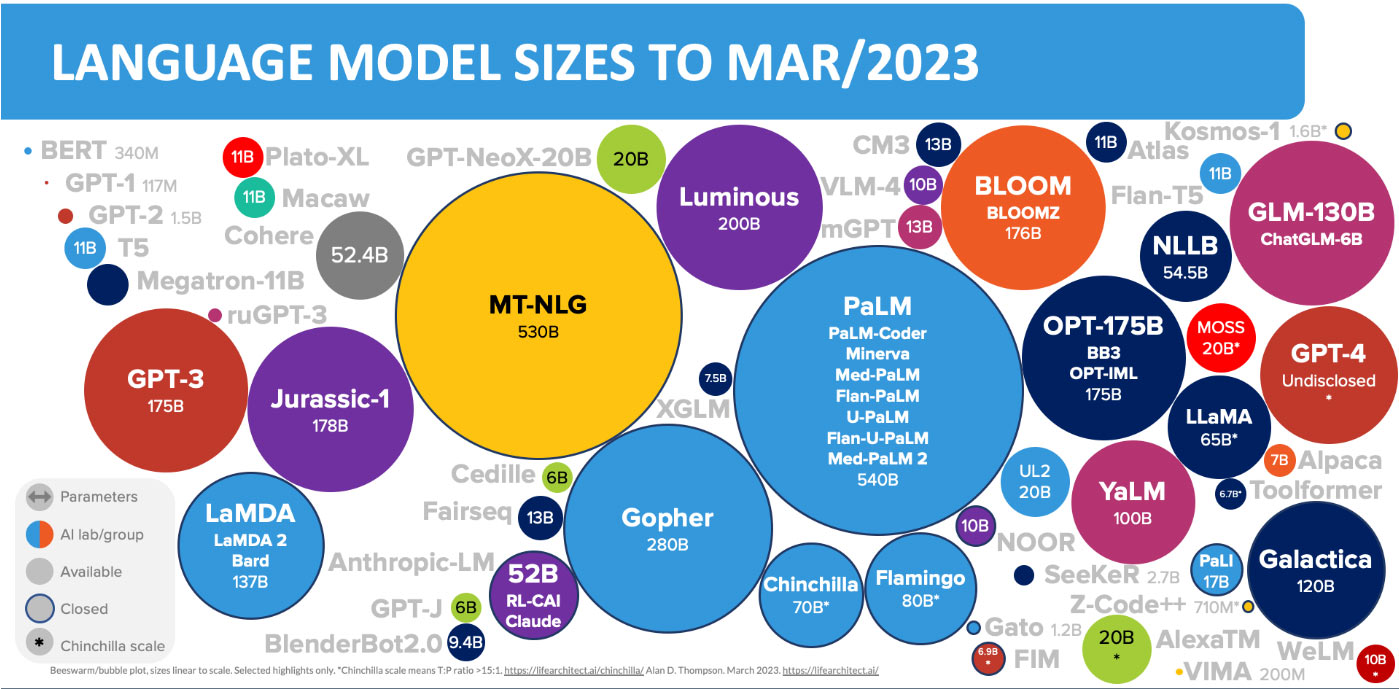

Někdy o něm také můžeme číst jako o LLM — Large Language Model. Je to program, který je schopen analyzovat a vytvářet texty. V současnosti je nejznámější model GPT-4, který můžete využívat v rámci aplikace ChatGPT.

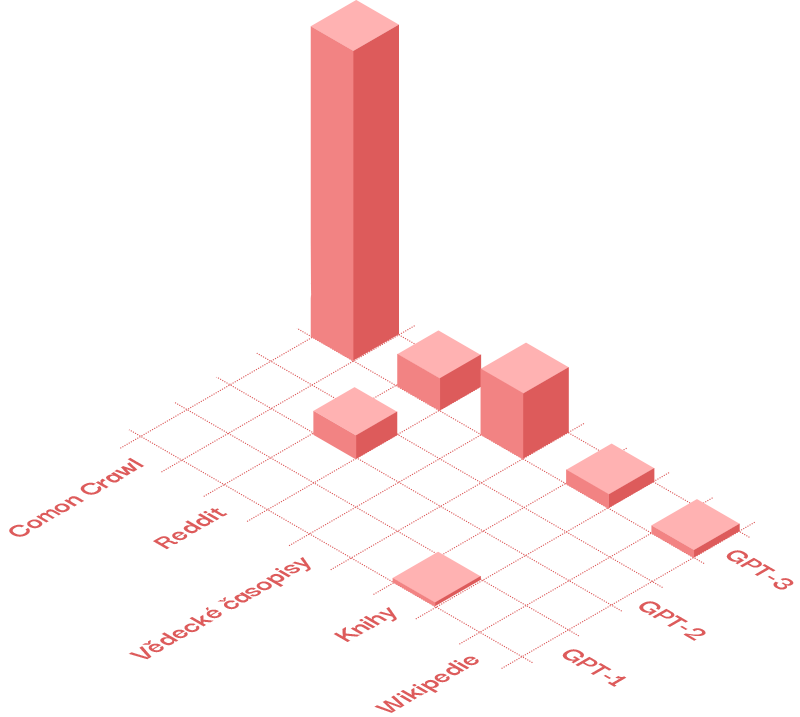

LLM jsou trénovány na obrovském množství textů, kterým se říká korpusy. To mohou být třeba digitalizované knihy, články, obsah Wikipedie a další. Takto se například vyvíjel model GPT [zdroj]:

Knižní korpus GPT-1

Romantické knihy: 26,1 %

Fantasy: 13,6 %

Sci-fi: 7,5 %

Pro dospívající: 6,8 %

Thriller: 5,9 %

Knihy o upírech: 5,4 %

Mysteriózní: 5,6 %

Další...

Common Crawl

Databáze Common Crawl je veřejně dostupný archiv webových stránek. Je vytvářen pravidelným procházením (crawlováním) webu a ukládáním obsahu.

Velké jazykové modely mají svou vnitřní reprezentaci našeho světa. Je vytvořena pomocí tzv. vektorů. Představte si model jako obrovský mnohodimenzionální prostor, v němž každé slovo (token) má svou přesnou polohu. Té se říká vektor a můžete si ho představit jako souřadnici. Různá slova mají k sobě v různých kontextech blíže než k jiným.

Například když napíšete do ChatGPT prompt:

Vygeneruj recept na volské oko.

slovo „oko“ se bude nacházet v tomto kontextu jinde, než když napíšete:

Popiš, jak vzniká obraz na sítnici oka.

Zásadní podíl na rozvoji této technologie má i český vědec Tomáš Mikolov.

Mimo aplikace ChatGPT můžete pro komunikaci s LLM využít třeba také Google Gemini nebo Microsoft Copilot nebo Claude AI. Vše kolem chatbotů naleznete na stránce Chatboti ve škole.

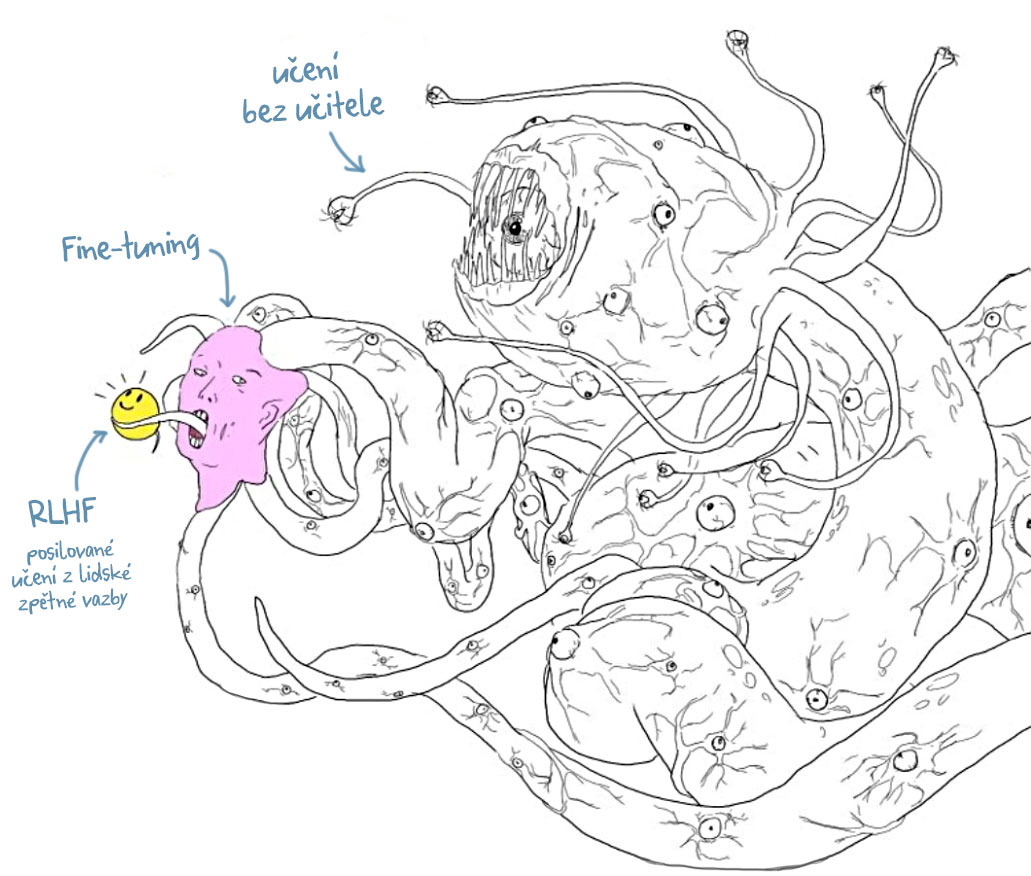

Velké zvíře na obrázku znázorňuje všechna data, na kterých byl GPT natrénován. S nadsázkou se ale my uživatelé bavíme pouze se žlutým sluníčkem. Tedy částí, která „nepapouškuje“ neetické nebo například nebezpečné věci. Vývojáře to stálo velké množství času a financí.

Zdroj obrázku: neznámý kreativec, X (Twitter)

Zdroj infografiky: lifeArchitect

Velmi zajímavý nástroj je také tzv. Tokenizer. LLM totiž „nepřemýšlí“ ve znacích, ale v tokenech. V tomto nástroji se můžete podívat, jak jsou věty vystavěné pomocí tokenů. Zajímavé je také porovnat české a anglické texty — uvidíte tak na vlastní oči, proč v angličtině funguje ChatGPT často lépe.

Toto je konec teoretické části o AI.

My v AI dětem to víme, vážně. Ale je dobré znát alespoň pár teoretických konceptů.

AI dětem, z.s.

IČ: 17914582

Datovka: 4czjq6u

Číslo účtu: 2002446742/2010

Poptáváte vzdělávací akci či spolupráci?

Ozvěte se Kláře na: klara@aidetem.cz

Další kontakty naleznete v sekci Lidé.